Açıklanabilir Yapay Zeka

Açıklanabilir Yapay Zeka (Explainable AI – XAI) ve Açıklanabilirlik Yöntemleri

Yapay zeka (YZ) ve makine öğrenmesi (MÖ) modelleri, günümüzde birçok alanda karmaşık problemleri çözmek için kullanılmaktadır. Ancak, bu modellerin nasıl çalıştığını anlamak ve verdikleri kararların arkasındaki nedenleri bilmek, özellikle kritik uygulama alanlarında açıklanabilir yapay zeka teknikleri açısından büyük önem taşır. Bu ihtiyacı karşılamak için “Açıklanabilir Yapay Zeka” (Explainable AI – XAI) kavramı ortaya çıkmıştır.

Açıklanabilir Yapay Zeka Nedir?

Açıklanabilir Yapay Zeka, YZ sistemlerinin karar verme süreçlerini şeffaf ve anlaşılır hale getirmeyi amaçlayan bir dizi yöntem ve tekniktir. Bu sayede, modellerin neden belirli bir tahminde bulunduğu, hangi faktörlerin kararı etkilediği ve modelin güvenilirliği gibi konular daha iyi anlaşılabilir. Özellikle sağlıkta yapay zeka uygulamaları, finansal analizlerde makine öğrenmesi ve hukuk gibi alanlarda, YZ modellerinin açıklanabilirliği kullanıcıların bu sistemlere güven duymasını sağlar ve etik sorunların önüne geçer.

Açıklanabilirlik ve Model Karmaşıklığı Arasındaki Denge

YZ modelleri genellikle iki kategoriye ayrılır: açıklanabilir (şeffaf) modeller ve “kara kutu” modeller. Doğrusal regresyon modelleri ve karar ağaçları gibi şeffaf yapılar, basit yapıları sayesinde karar süreçlerini anlamayı kolaylaştırır. Ancak, bu modeller karmaşık veriler üzerinde yeterli performansı gösteremeyebilir. Diğer yandan, derin öğrenme (deep learning) ve yapay sinir ağları gibi karmaşık modeller yüksek doğruluk sağlar, ancak iç işleyişleri anlaşılması zor olduğundan açıklanabilirlikleri düşüktür. Bu nedenle, model performansı ile açıklanabilirlik arasında bir karşıtlık bulunmaktadır. Model karmaşıklığı arttıkça, açıklanabilirlik azalır.

Açıklanabilirlik Yöntemleri

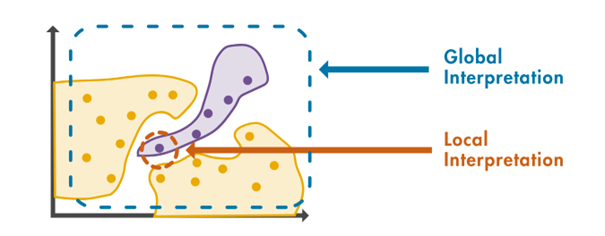

Makine öğrenmesinde açıklanabilirlik yöntemleri, modelin genel davranışını anlamaya yönelik “global” ve tek bir tahminin nedenlerini açıklamaya yönelik “lokal” olmak üzere ikiye ayrılır.

Global Yöntemler

Bu yöntemler, modelin genel yapısını ve hangi değişkenlerin kararları en çok etkilediğini belirlemeye çalışır. Örneğin, değişken önem sıralamaları ve kısmi bağımlılık grafikleri, modelin genel davranışını anlamada kullanılır.

Lokal Yöntemler

Lokal yöntemler, belirli bir tahminin arkasındaki nedenleri açıklamaya odaklanır. En popüler lokal açıklanabilirlik tekniklerinden biri LIME (Local Interpretable Model-agnostic Explanations) yöntemidir. LIME, herhangi bir makine öğrenimi modelinin tahminlerini açıklamak için kullanılan bir tekniktir. Modelin tahminlerini yorumlanabilir bir modele yaklaştırarak, açıklayıcı değişkenlerin tahmin üzerindeki etkilerini ve önem derecelerini ortaya koyar.

1. Değişken Önem Analizi (Permutation Feature Importance)

MATLAB’daki en sık kullanılan açıklanabilirlik yöntemlerinden biri değişken önem analizidir. Bu yöntem, bir değişkenin modele katkısını, o değişkenin değerlerini rastgele karıştırarak ölçer. Böylece hangi değişkenlerin modelin performansına en fazla etki ettiği anlaşılır. MATLAB’da permutationImportance fonksiyonu bu analizi kolaylaştırır.

2. Kısmi Bağımlılık Grafikleri (Partial Dependence Plots – PDP)

Kısmi bağımlılık grafikleri, belirli bir değişkenin model çıktısı üzerindeki genel etkisini görselleştirir. Örneğin, kredi verme modellerinde yaş veya gelir gibi değişkenlerin kredi onayı üzerindeki etkisini anlamakta kullanılır. MATLAB’da bu grafikler partialDependence fonksiyonu ile elde edilir.

3. LIME (Local Interpretable Model-agnostic Explanations)

LIME yöntemi, karmaşık modellerin tek tek tahminlerini açıklamak için kullanılır. LIME, karmaşık bir modeli basit ve anlaşılır yerel modellerle açıklar. Özellikle sağlık alanında, hastaların teşhis kararlarının doktorlar tarafından anlaşılmasını sağlar. MATLAB’da lime fonksiyonu sayesinde bu yöntem kolayca uygulanabilir.

4. SHAP (SHapley Additive exPlanations)

Oyun teorisi temelinde geliştirilen SHAP yöntemi, modelin tahminleri üzerindeki her bir değişkenin katkısını ayrı ayrı hesaplar. Bu yöntem, finans sektöründe kredi başvurularının neden kabul edildiğini veya reddedildiğini açıklamak için yaygın olarak kullanılır. MATLAB’da shapley fonksiyonu ile rahatça kullanılabilir.

5. Grad-CAM (Gradient-weighted Class Activation Mapping)

Derin öğrenme modellerinde özellikle görüntü sınıflandırma uygulamalarında kullanılan Grad-CAM, modelin hangi görsel bölgeleri dikkate alarak karar verdiğini görsel olarak açıklar. Bu yöntem sayesinde, örneğin tıbbi görüntülerde teşhis modellerinin kritik bölgeleri doğru şekilde belirleyip belirlemediği kolayca incelenebilir.

6. ICE Grafikleri (Individual Conditional Expectation)

ICE grafikleri, belirli bir değişkenin farklı değerlerinin tek tek gözlemler üzerindeki etkisini analiz etmek için kullanılır. Bu yöntem, özellikle sigorta ve risk değerlendirme modellerinde, bireysel kararların nasıl değiştiğini anlamak için tercih edilir. MATLAB’da plotPartialDependence fonksiyonu ICE grafikleri için kullanılabilir.

7. Surrogate (Vekil) Modeller

Karmaşık modellerin genel davranışlarını anlamak için daha basit ve yorumlanabilir modellerle taklit edilmesi yöntemidir. Surrogate modeller, karmaşık karar süreçlerinin arkasındaki genel mantığı anlamak için mükemmel bir araçtır. MATLAB’da bu amaç için karar ağaçları (fitctree) ve lineer regresyon (fitrlinear) modellerini kolaylıkla kullanabilirsiniz.

8. Model-Specific (Modele Özgü) Teknikler

Bazı modeller doğrudan yorumlanabilir yapıdadır. Karar ağaçları veya doğrusal regresyon gibi modeller bu sınıfa girer. MATLAB, bu tip modellerin doğrudan görselleştirilmesi ve yorumlanabilmesi için güçlü araçlar sunar. Bu sayede modellerin karar süreçleri kolayca anlaşılır hale gelir.

MATLAB’da Açıklanabilirlik için Araçlar

MATLAB’da açıklanabilirlik yöntemlerini kullanabilmek için çeşitli araç kutuları bulunmaktadır:

- Statistics and Machine Learning Toolbox: PDP, ICE, Değişken Önem Analizi gibi yöntemleri sağlar.

- Deep Learning Toolbox: Grad-CAM gibi derin öğrenme açıklanabilirlik tekniklerini içerir.

- Explainable AI Toolbox: LIME ve SHAP gibi modern yöntemleri kolaylıkla uygulamanıza yardımcı olur.

Açıklanabilir Yapay Zekanın Önemi

Açıklanabilirlik, YZ modellerinin güvenilirliği ve etik kullanımı açısından kritik bir rol oynar. Kullanıcılar, modellerin nasıl çalıştığını anladıklarında, bu modellere daha fazla güvenirler ve sonuçlarını kabul etmeye daha yatkın olurlar. Özellikle sağlık hizmetleri, finansal kararlar ve yasal süreçler gibi yüksek riskli alanlarda, açıklanabilirlik, yanlış kararların önüne geçmek ve olası zararları minimize etmek için hayati öneme sahiptir.

Açıklanabilirlik Tekniklerinin Uygulama Alanları

Sağlık Hizmetleri

Tıbbi teşhis ve tedavi önerilerinde bulunan YZ modellerinin karar süreçlerinin anlaşılması, hem doktorların hem de hastaların bu sistemlere güvenmesini sağlar. Örneğin, bir modelin neden belirli bir hastalığı teşhis ettiğini açıklayabilmesi, doktorların bu teşhisi değerlendirmesine ve doğru tedavi planını oluşturmasına yardımcı olur.

Finans

Kredi skorlama ve dolandırıcılık tespiti gibi finansal uygulamalarda, modellerin kararlarının açıklanabilir olması, müşterilere karşı şeffaflık sağlar ve yasal uyumluluğu destekler. Müşteriler, kredi başvurularının neden reddedildiğini anladıklarında, finansal kurumlara olan güvenleri artar.

Hukuk

Yasal belgelerin analizinde ve adli karar destek sistemlerinde kullanılan YZ modellerinin açıklanabilirliği, adil ve şeffaf yargı süreçleri için gereklidir. Açıklanabilirlik, yargıçların ve avukatların, modellerin önerilerini değerlendirmesine ve gerektiğinde sorgulamasına olanak tanır.

Açıklanabilir Yapay Zekanın Geleceği

YZ modellerinin giderek daha karmaşık hale gelmesiyle, açıklanabilirlik ihtiyacı da artmaktadır. Araştırmacılar ve mühendisler, yüksek performanslı ve aynı zamanda açıklanabilir modeller geliştirmek için çalışmaktadır. Bu bağlamda, hibrit modeller ve yeni açıklanabilirlik teknikleri üzerine yapılan çalışmalar önem kazanmaktadır. Örneğin, şeffaf ve kara kutu modellerin birleşiminden oluşan hibrit modeller, hem yüksek performans hem de açıklanabilirlik sunmayı hedefler.

Sonuç

Açıklanabilir Yapay Zeka, YZ ve MÖ modellerinin güvenilirliği, etik kullanımı ve kullanıcı kabulü açısından büyük önem taşır. MATLAB ile açıklanabilirlik uygulamaları, modellerin karar süreçlerini aydınlatarak daha etik ve güvenli yapay zeka çözümleri sunulmasını sağlar.

Model geliştiricileri ve kullanıcıları, açıklanabilirlik tekniklerini uygulayarak, bu sayede modellerin karar süreçlerini daha iyi anlayabilirler.

İçindekiler

Toggle- Açıklanabilir Yapay Zeka (Explainable AI – XAI) ve Açıklanabilirlik Yöntemleri

- Açıklanabilir Yapay Zeka Nedir?

- Açıklanabilirlik ve Model Karmaşıklığı Arasındaki Denge

- Açıklanabilirlik Yöntemleri

- Global Yöntemler

- Lokal Yöntemler

- 1. Değişken Önem Analizi (Permutation Feature Importance)

- 2. Kısmi Bağımlılık Grafikleri (Partial Dependence Plots – PDP)

- 3. LIME (Local Interpretable Model-agnostic Explanations)

- 4. SHAP (SHapley Additive exPlanations)

- 5. Grad-CAM (Gradient-weighted Class Activation Mapping)

- 6. ICE Grafikleri (Individual Conditional Expectation)

- 7. Surrogate (Vekil) Modeller

- 8. Model-Specific (Modele Özgü) Teknikler

- MATLAB’da Açıklanabilirlik için Araçlar

- Açıklanabilir Yapay Zekanın Önemi

- Açıklanabilirlik Tekniklerinin Uygulama Alanları

- Açıklanabilir Yapay Zekanın Geleceği

- Sonuç